No dia 13 de abril, o personal trainer José Antônio Lima, de 23 anos, foi retirado por cinco policiais militares das arquibancadas do estádio Arena Batistão, em Aracaju. José acompanhava a final do campeonato sergipano, disputado entre Confiança e Sergipe, antes de ser identificado por uma ferramenta de reconhecimento facial e conduzido para uma sala, onde foi revistado e interrogado.

Toda a ação foi filmada e o torcedor publicou os vídeos na rede social X (antigo Twitter). "Parece um delinquente, um foragido, mas esse aí sendo conduzido pela polícia SOU EU", afirmou ele no perfil, onde a publicação foi vista mais de 4 milhões de vezes até o momento.

Durante a abordagem, descrita por José como "ríspida", os agentes pediram para ele colocar as mãos para trás, depois o revistaram e revelaram que ele fora identificado pela ferramenta, que "dificilmente erra".

Mas, após confirmarem a identidade de José, os policiais perceberam o engano, pediram desculpas, confirmaram que aquela era uma abordagem padrão e o liberaram. No campo, o Confiança, time do coração de José, foi campeão nos pênaltis.

Não foi o primeiro erro recente de um sistema do tipo operando na capital de Sergipe. Durante o festival Pré-Caju 2023, em novembro, um sistema com 27 câmeras com capacidades de reconhecimento facial identificou positivamente Thaís Santos, de 31 anos, como foragida da Justiça.

Em um relato nas redes sociais, Thaís afirmou ter sido levada para uma averiguação de documentos no dia 4, mas liberada após constatado o erro. Mas a situação piorou quando ela foi abordada uma segunda vez, no mesmo festival: "fui humilhada publicamente , maltratada e levada como uma meliante para o carro da polícia , sem que ao menos pudesse me defender ou me explicar", explicou ela no Instagram.

Na época, a Secretaria de Segurança Pública do estado reiterou, por meio de uma nota oficial, que a "tecnologia não tem 100% de precisão" e que "três pessoas com mandados de prisão foram localizadas e presas nos dois primeiros dias" do evento com o auxílio do sistema.

Com os dois erros em um curto intervalo de tempo, o governador Fábio Mitidieri (PSD) anunciou, no dia 15 de abril, que o uso de equipamentos de reconhecimento facial pela Polícia Militar seria suspenso imediatamente.

Nas redes sociais, o governador reconheceu a "importância da tecnologia para a segurança pública", mas afirmou que os "instrumentos de segurança do Estado não podem constranger nossos cidadãos".

Reconhecimento facial é uma tendência global na segurança pública. Também é quase onipresente em celulares, prédios e meios de transporte. Países como Nova Zelândia, Austrália e Índia contam com múltiplos sistemas avançados de reconhecimento facial automatizado — muitas das vezes, cada força policial, de fronteira ou de investigação financeira possui programas próprios, que operam separadamente.

O Departamento de Estado dos Estados Unidos e o FBI (Departamento Federal de Investigação) possuem alguns dos maiores aparatos de identificação do planeta, com acesso a identidades e dados de milhões de cidadãos do país e estrangeiros. A China opera um sistema chamado SkyNet, que possui até 600 milhões de câmeras, boa parte delas com tecnologia de reconhecimento, segundo o jornal South China Morning Post. O próximo plano do país seria construir um sistema de vigilância na lua, onde serviria para proteger uma futura base no satélite.

O Reino Unido é um dos países com mais câmeras de vigilância do mundo

J D Mack/Flickr (Sob Licença Creative Commons)O Reino Unido também é um caso especial: em maio de 2017, policiais do Reino Unido realizaram a primeira prisão do país com o uso de um sistema automático de reconhecimento facial, instalado em uma viatura que percorria as ruas de Gales do Sul. "Nossa abordagem ao policiamento está muito centrada na intervenção precoce e na ação imediata e positiva; a introdução do reconhecimento facial ajuda a apoiar esses objetivos", disse, na época, o comissário policial Alun Michael, de Gales do Sul.

Hoje, o governo britânico conta com cerca de 5 milhões de câmeras de vigilância, também com grande parte delas conectadas a sistemas de monitoramento que incluem tecnologia de reconhecimento facial. Cerca de 950 mil delas estão em Londres. Lojistas do país criaram uma rede própria, chamada Facewatch, que identifica possíveis golpistas antes deles praticarem crimes financeiros em algum estabelecimento.

O Brasil também segue a tendência. A cidade de São Paulo começou a implantar 10 mil câmeras avançadas, com previsão de dobrar o número até o fim de 2024. O Rio de Janeiro possui 130 dispositivos do tipo, e, segundo dados oficiais, contou com o auxílio de câmeras para realizar mais de 100 prisões somente este ano — entre eles, a captura de 30 foragidos.

Mas, grandes sistemas públicos estão longe de ser unanimidade. Devido à dúvidas e críticas com relação à privacidade, cidades norte-americanas como São Francisco, Boston e Baltimore, e os estados de Vermont e Maine proibiram totalmente o uso de reconhecimento facial. É nesse embate jurídico, tecnológico e social que muitos governos se encontram hoje: priorizar a vigilância total em nome da segurança ou dar alguma margem de privacidade para seus cidadãos?

É o que aponta em entrevista ao R7 o advogado Rony Vainzof, especialista em direito digital e segurança cibernética e professor da Escola Paulista de Direito

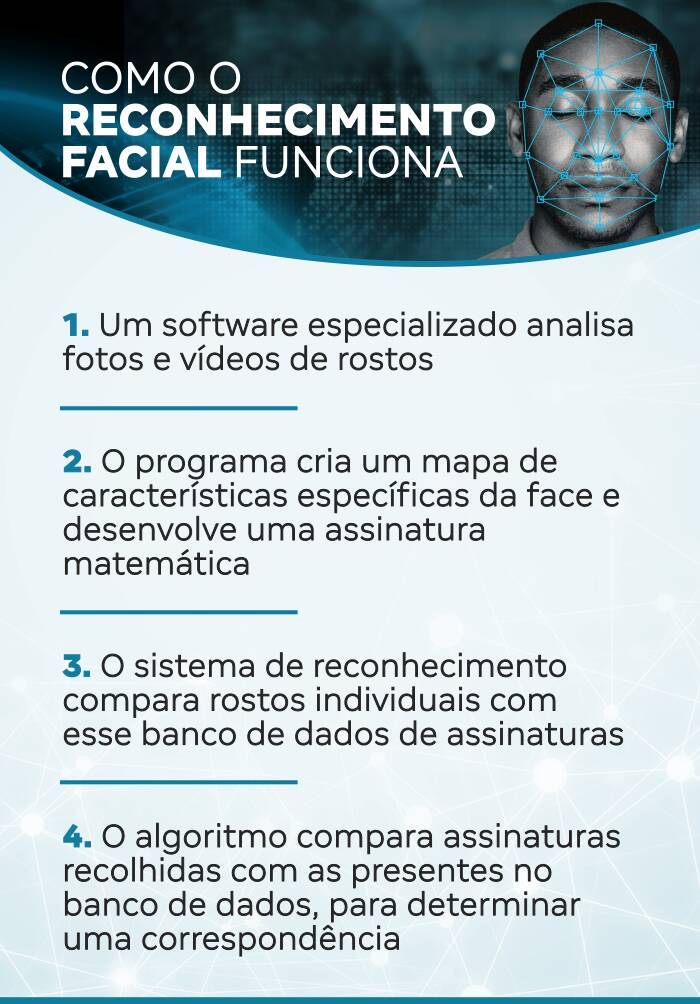

Superficialmente, o funcionamento das mais modernas e automatizadas tecnologias do tipo é simples de entender: algoritmos comparam, em tempo real, rostos de fotos ou que são detectados por câmeras, com imagens de bancos de dados — principalmente de suspeitos, foragidos e pessoas desaparecidas. O sistema, então, envia notificações para operadores humanos, que devem confirmar a compatibilidade dos dois rostos. Quanto maior a resolução das fotos, menores as chances de erros na identificação.

Mas esse estágio de precisão e velocidade tecnológica levou décadas para ser alcançado. O primeiro grande passo no desenvolvimento do reconhecimento facial automatizado foi dado em meados da década de 1960, quando o trio de especialistas em inteligência artificial Woody Bledsoe, Helen Chan Wolf e Charles Bisson começou a treinar massivamente computadores para identificar rostos humanos, baseado em coordenadas matemáticas, como distância entre pupilas e linhas de cabelo.

Mas, foi apenas em 1993 que a tecnologia começou a ser usada nos moldes contemporâneos. Ao invés de duas imagens escolhidas em bancos de imagens, como é feito com impressões digitais, os novos métodos conseguiam varrer ativamente gravações de câmeras com resolução suficiente.

O salto foi feito principalmente por empresas ligadas à pesquisas militares norte-americanas, estabelecidas pela Darpa (Agência de Projetos de Pesquisa Avançada de Defesa), a exemplo da Viisage Technology. Em 2001, empresas já trabalhavam com detecção automática de rostos em tempo real diretamente de gravações de vídeos.

Sistemas modernos são capazes de fazer escaneamento de rostos em todas as dimensões

Robert Rathe/NIST.gov (Sob Licença Creative Commons)Em 1997, a Viisage chegou a vender um protótipo de um programa que fazia retratos falados com reconhecimento facial para a Polícia Civil de São Paulo, um projeto considerado bem-sucedido, mas que não prosperou.

"Na época, existiam desafios financeiros — as câmeras avançadas eram muito caras — e tecnológicos, por causa dos algoritmos. Mas esse foi um projeto pioneiro, em parceria com essa empresa americana", conta José Mariano de Araújo Filho, delegado da Polícia Civil de São Paulo e especialista em segurança da informação, em entrevista ao R7.

"Fizemos várias experiências, com vários níveis de iluminação e distância e os resultados foram sensacionais", completa. De acordo com o especialista, a Viisage chegou até a pedir ajuda à autoridades brasileiras para treinar algoritmos com rostos e biotipos brasileiros e latinos, para melhorar a qualidade dos resultados.

Tanto o estado de São Paulo quanto a capital possuem sistemas próprios de vigilância de larga escala que usam reconhecimento facial e buscam, em teoria, flagrar ou evitar crimes. Embora os números oficiais demonstrem eficiência nos resultados na diminuição da criminalidade, a história do desenvolvimento deles é repleto de críticas, atrasos, problemas de contrato e promessas nunca cumpridas.

O Detecta foi inaugurado pela gestão do então governador Geraldo Alckmin, em agosto de 2014, como resultado de uma parceria com a Microsoft e o Departamento de Polícia de Nova York. O sistema, operado pela Secretaria de Segurança Pública de São Paulo, usa câmeras integradas a um vasto banco de dados estadual de informações policiais, e é usado principalmente para levantar informações de veículos irregulares que trafegam no estado.

Tecnologia de reconhecimento facial em operação no metrô de São Paulo

Flickr/Governo do Estado de São PauloNo entanto, um relatório do Tribunal de Contas do Estado (PDF), finalizado em julho de 2016, afirmou que o Detecta ainda era incapaz de analisar crimes filmados na época. Segundo o TCE, que investigou o Detecta por 15 meses, faltava infraestrutura e treinamento para análise de dados, e os sistemas operacionais usados eram conflitantes. "Constatou-se que o Detecta ainda não oferece a ferramenta ‘vídeo analítico’, que seria capaz de identificar comportamentos, deixando de atender à demanda requerida pela SSP”, afirmou o tribunal, na conclusão do relatório, que apontou que ele ainda não apresentava "resultados efetivos para a segurança pública".

O problema foi também de software e de como lidar com ele, analisa o especialista José Mariano de Araújo. "Eu fui, durante muito tempo, um dos coordenadores do Detecta da parte da Polícia Civil. E, principalmente na segurança pública, não adianta apenas ter câmeras espalhadas na cidade, é necessário o que é conhecido como 'consciência situacional', que é uma orientação de acordo com a situação que você tem, um gerenciamento de tomada de decisões baseados nos diversos alertas que essas tecnologias geram." Essa integração era um dos itens que faltava para a efetividade do Detecta.

Da parte do fabricantes também existem falhas. "Durante uma licitação, fornecedores oferecem diversas tecnologias. A empresa escolhida sabe dos problemas que o produto tem, mas não os revela. A maioria desses sistemas não é customizado, e geralmente espelham tecnologias americanas, europeias ou chinesas, sem adaptação para uma realidade brasileira. Essas 'caixinhas fechadas' funcionam, mas não trabalham os casos excepcionalizados, que geram os problemas que afetam liberdades de uma pessoa", completa o especialista, que afirma que atualizações pagas às vezes resolvem as questões.

Os algoritmos de reconhecimento evoluíram rapidamente nos últimos anos

Flickr/Governo do Estado de São PauloA atual gestão estadual trabalha com uma espécie de evolução do Detecta, denominado Muralha Paulista e lançado em 2023. Segundo dados de janeiro da Secretaria de Segurança Pública, foram firmados acordos com 630 municípios e 25 entidades privadas do estado para compartilhar imagens de câmera de segurança.

No primeiro teste do sistema em um grande evento internacional — o Grande Prêmio de São Paulo de Fórmula 1, em novembro de 2023 —, o governo anunciou que prendeu 10 foragidos com mandados de prisão em aberto, por crimes como roubo e pedofilia.

Apesar da efetividade demonstrada recentemente para realizar prisões, o crescimento de sistemas do tipo, cada vez mais presente em grandes metrópoles e operados por órgãos públicos e grupos privados, levantou uma série de questionamentos e preocupações nos últimos anos, principalmente com relação à privacidade e segurança dos dados.

"Um risco a ser considerado com particular cuidado por causa de tecnologias de reconhecimento facial é o grau de intrusão a nossa privacidade: o quão confortáveis estamos dando ao Estado a capacidade de nos localizar onde quer que estejamos? Por exemplo, manifestantes irão sentir-se confortáveis em posicionar-se em temas polêmicos, se estiverem sendo constantemente vigiados?", questiona Rony Vainzof.

Em agosto do ano passado, após uma série de idas e vindas e questionamentos jurídicos, a Prefeitura de São Paulo assinou contrato para a implantação do sistema Smart Sampa, descrito como "o maior sistema de monitoramento por câmeras e outras tecnologias integradas". Segundo o projeto, o sistema contará com "20 mil câmeras inteligentes de segurança", e a possibilidade de integração com 20 mil outros dispositivos privados, de moradores e empresas da capital paulista. A previsão de instalação é de 18 meses.

No ato da assinatura, o prefeito Ricardo Nunes afirmou que o Smart Sampa contará com um "controle muito rígido", principalmente após diversas discussões com o Tribunal de Contas e o Judiciário. Para evitar erros como as abordagens em Aracaju, o sistema paulistano só utilizará dados com "mais de 90% de similaridade na biometria facial", e só enviará as detecções para policiais após análise de um "comitê integrado à Controladoria Geral do Município". O plano é integrar o monitoramento urbano das Polícia Civil e Militar, da GCM (Guarda Civil Municipal), da CET (Companhia de Engenharia de Tráfego), Samu, Metrô e CPTM.

Em 18 de maio de 2023, o edital do sistema chegou a ser suspenso na Justiça, após vereadoras do PSOL entrarem com uma ação popular, em que afirmavam que tecnologias do tipo são conhecidas por possuírem caráter discriminatório, argumento que recebeu manifestação favorável do Ministério Público estadual. A decisão foi revertida cinco dias depois no Tribunal de Justiça de São Paulo, que considerou não existirem, até o momento, "evidência de que a implementação de videomonitoramento reforce eventual discriminação social e racial".

Para evitar prisões equivocados, registradas em sistemas de outros estados, a Secretaria Municipal de Segurança Urbana afirma, em resposta ao R7, que o "Smart Sampa possui um avançado sistema de autenticação para assegurar a proteção dos dados, bem como estabelecer diretrizes éticas para evitar qualquer discriminação ou violação dos direitos individuais no uso da tecnologia".

O órgão explica ainda que o sistema "não gera a prisão de um indivíduo", e conta com um "avançado protocolo de validação dos alertas", que necessita da "validação de um agente humano da central de monitoramento" antes de qualquer ação. O programa conta ainda com um "time multidisciplinar" composto por especialistas "do Brasil, China e EUA", que usam "modelos de inteligência artificiais aplicadas e treinadas em faces do mundo inteiro".

O pedreiro José Domingos Leitão, de 54 anos, dormia em sua casa em Ilha Grande, no Piauí, quando foi acordado por policiais civis com armas na mão. Todos na casa despertaram com chutes na porta da residência, gritos e ordens para permanecerem calados. Era madrugada de 7 de outubro de 2020, quando as autoridades o embarcaram em uma aeronave oficial e o transportaram para o Departamento de Polícia Especializada, em Brasília.

Ele só saberia horas depois, mas fora identificado erroneamente por um programa de reconhecimento facial como um falsificador de documentos para conseguir um cartão de crédito. A comparação de rostos foi feito com base em imagens de uma câmera de segurança e analisada por especialistas do Instituto de Identificação, com base em um banco de dados nacional.

Jose Domingos Leitão foi identificado positivamente por um algoritmo, antes de ser preso

Reprodução/Secretaria de Segurança Pública do Distrito FederalJosé Domingos não possuía antecedentes criminais e, no momento do crime, em uma loja de departamentos do Distrito Federal, estava na casa de um vizinho, onde construía um muro. "É você mesmo que estamos procurando e você sabe o que fez", disse a delegada responsável pela operação, de acordo com o pedreiro, em entrevista dada do R7 em dezembro de 2021.

O equívoco durou três dias, tempo em que a Polícia Civil retificou o laudo e transportou José Domingos de volta ao Piauí. Em resposta dada na época, a Procuradoria do Distrito Federal negou a culpa dos policiais civis e disse que eles seguiram uma decisão judicial.

Em entrevista ao R7, Carlos Alberto de Castro Júnior, advogado de José, destaca que a situação pode ser considerada grave, e "gerou danos psicológicos, financeiros e sociais não somente a ele, mas também a sua família".

"Por ser um sistema que visa identificação, resultando em um laudo de comparação facial, qualquer margem de erro que ele possa oferecer não deveria ser admitida, uma vez que isso incorre na restrição da liberdade de alguém", afirma Carlos Castro Júnior.

O erro foi cometido por uma falha temporal: a foto de José que gerou a correspondência positiva era de cerca de 30 anos atrás, segundo a esposa dele.

Após a prisão por engano, José Domingos enfrentou problemas para dormir, tomou remédios e processou o Distrito Federal em R$ 50 mil por danos morais. Segundo Carlos Castro Júnior, no momento, o processo foi enviado para a Justiça Federal, onde "aguarda atualmente decisão para dar andamento, momento em que será feita a produção de provas, bem como a oitiva de testemunhas que irão corroborar a ocorrência do dano moral pleiteado". De acordo com o advogado, o processo também tem como objetivo aprimorar sistemas de identificação facial automática, para evitar a prisão de outros inocentes.

A Secretaria de Segurança Pública do Distrito Federal não respondeu os pedidos de comentário feitos pelo R7.

Em 2013, as revelações bombásticas do analista de inteligência Edward Snowden mudaram a percepção global de bilhões de pessoas sobre privacidade e anonimato. Os programas expostos nos documentos vazados pelo denunciante — com siglas como PRISM, PREFER e MYSTIC, antes ultrassecretas — mostraram que a coleta de informações por agências de espionagem ocorriam em níveis que poucos eram capazes de imaginar.

As denúncias de Snowden decretaram uma nova era da web, e escancararam a vigilância indiscriminada de governos, que ocorre de forma global e muito mais desenfreada que nos aparatos nacionais de segurança pública. O monitoramento é parte integrante do fluxo de dados da própria internet, especialistas concluíram quase imediatamente. Não por acaso, o CEO da Meta, Mark Zuckerberg escondeu o rosto dos filhos em um post de 4 de julho de 2023.

Antes de encaminhar os documentos a jornalistas em Hong Kong, Snowden não tinha rosto e se identificava apenas como "Verax" — um codinome que significa, em latim, "o que diz a verdade". Um dos slides mostrados por ele revelou que a NSA (Agência de Segurança Nacional, especializada em inteligência cibernética), em 2011 coletava "milhões de imagens por dia", o que incluía 55 mil delas com "qualidade de reconhecimento facial". Mesmo na época, defensores de liberdades civis já expressavam preocupações com a falta de legislação que regulamentasse a coleta, bem como garantisse alguma forma de privacidade em vias públicas.

Ainda que não fosse o foco no momento, os documentos mostraram uma lenta evolução das redes de coleta: antes abastecidos apenas com fotos de sistemas oficiais, como carteiras de motoristas, agências de segurança davam um passo além e desenvolviam meios para coletar fotos do Facebook e outras redes sociais, imagens anexadas em emails e câmeras de segurança. O salto de processamento computacional e o desenvolvimento de poderosos algoritmos de análise permitiram que essas imagens de rostos sejam combinadas com outras informações e dados biométricos.

Edward Snowden denunciou vigilância massiva por agências de segurança

@gageskidmore/Flickr (Sob Licença Creative Commons)As redes sociais mostraram de modo escancarado que "somos cúmplices de nossa própria vigilância", "ao compartilhar — por vontade própria e conscientemente ou não — nossas informações pessoais no domínio público online", segundo afirmou o sociólogo David Lyon, diretor do Centro de Estudos de Vigilância e professor da Universidade do Queen, em Ontário, no artigo Cultura da Vigilância: Exposição e Ética na Modernidade Digital, de 2017.

Segundo o pesquisador, não apenas "vivemos uma cultura de vigilância sem precedentes", como "participamos ativamente dela". Esse modo de vigilância contemporâneo se difere dos praticados no século 20, por ser "um modo de vida", já quase plenamente "internalizado e parte das reflexões e práticas diárias" de populações inteiras.

Agências como o FBI e a NSA praticam uma ativa "vigilância sem suspeito", da qual big techs coletam dados e os partilham com órgãos governamentais, quase sempre com o máximo possível de segredo, que deixam consequências na população.

"A presença massiva de tecnologias de vigilância pode ter várias implicações psicológicas e comportamentais nos cidadãos, incluindo o aumento da ansiedade e da autocensura, além da alteração de padrões de comportamento em espaços públicos", completa Rony Vainzof.

Um dos maiores exemplos dessa realidade de coleta global de dados é a startup Clearview AI, que mantém um banco de dados com cerca de 20 bilhões de imagens de rostos de pessoas, extraídas sem consentimento de redes sociais, sites de empregos e outras fontes abertas na internet. Clientes, como departamentos de polícia de diversos países do mundo, pagam para fazer consultas a tais coleções e procurar identificações positivas.

Um vazamento massivo dos dados da empresa de 2020, revelou que ela tinha mais de 2.200 clientes em todo o mundo, o que inclui agências de aplicação da lei, empresas (a exemplo de bancos e grandes varejistas) e indivíduos. Até funcionários da Casa Branca usaram o serviço, em setembro de 2019. Além de revelar nome e aparência, os resultados de buscas da empresa também informam onde vivem, hábitos e pessoas que conhecem.

A Clearview AI foi fundada em 2016, por Hoan Ton-That, um australiano de descendência vietnamita, que se mudou para São Francisco, onde lançou apps de mídia social — incluindo o Trump Hair, que adicionava a cabeleira estranha de Donald Trump às pessoas em uma foto selecionada, que não fez muito sucesso.

O que empresa fez foi criar um banco mundial de fotos, incomparavelmente maior que as bases de dados oficiais de governos, geralmente limitadas a registros de motoristas e sistemas de saúde. Em fevereiro de 2017, após receber alguns milhões em investimento de capital risco, a empresa ofereceu seus serviços para o Departamento de Polícia de Indiana, que resolveu um caso em 20 minutos com o uso da tecnologia, e se tornou o seu primeiro cliente pagante.

Desde então, foi protagonista de diversas vitórias, como a prisão de agressores sexuais, fraudadores financeiros, brigões e sequestradores em todos os Estados Unidos. Também foi usado gratuitamente pelo governo da Ucrânia, nos esforços de identificar espiões russos e soldados mortos. Em 2022, a empresa chegou a fazer apresentações em uma feira internacional de segurança no Brasil. No entanto, seu algoritmo nunca foi estudado por acadêmicos, o que significa que não se sabe a quantidade de identificações errôneas que ele retorna.

Apesar de todo o sucesso internacional, a Clearview opera em um limbo legal, uma vez que claramente viola os termos de usos das centenas de sites que coleta imagens, além de não obter nenhum consentimento de seus usuários. Os holofotes tornaram a empresa um alvo internacional. A Clearview AI foi processada e multada pela Itália, Reino Unido e União Europeia, e declarada ilegal no Reino Unido, Grécia e França. Em maio de 2022, para encerrar um processo que tramitava nos Estados Unidos, a empresa parou de vender seus serviços para empresas e pessoas físicas.

"A Clearview AI está rapidamente se tornando tão tóxica que nenhuma agência de segurança credível, autoridade pública ou outra empresa vai querer trabalhar com eles", afirmou Ella Jakubowska, especialista em reconhecimento facial e biometria para a European Digital Rights, em entrevista ao MIT Technology Review.

A Clerview AI não retornou os pedidos de comentários feitos pelo R7.

"Não há nada mais perigoso que cogitar uma Terceira Guerra Mundial. Vale considerar se parte do perigo não seja talvez intrínseco ao uso incauto de máquinas de aprender. Ouvi repetidamente a declaração de que máquinas de aprender não podem sujeitar-nos a quaisquer novos perigos, porque podemos desligá-las à nossa vontade. Mas podemos mesmo? Para desligar efetivamente qualquer máquina devemos estar informados se o ponto de perigo chegou." Foi o que especulou de forma sombria o matemático norte-americano Norbert Wiener, em 1948, em seu seminal livro Cibernética.

Wiener foi um dos principais teóricos da automação e desenvolvimento computacional. Já em seus primeiros passos, o pesquisador demonstrou preocupações agudas com as implicações de suas descobertas, e quase oito décadas depois, muitas questões seguem em aberto — com a chegada dos algoritmos e inteligência artificial generativa, as perturbações explodiram.

Sem dúvidas, a tecnologia melhorou a precisão desde que os primeiros questionamentos vieram. Estudos extensos do início da década (PDF), feitos pela agência NIST (Instituto Nacional de Padrões e Tecnologia, espécie de Inmetro do governo dos EUA), apontaram que as taxas de acerto de tecnologias de reconhecimento facial eram maiores entre homens brancos e piores em negros e pessoas do leste asiático, especialmente mulheres. Isso abria a possibilidade de que mais prisões injustas fossem feitas entre as minorias do território norte-americano.

Desde 2018, ano em que a agência começou a investigar profundamente diversos algoritmos de reconhecimento facial, as taxas de erro diminuíram cerca de 90%, apontou uma atualização da investigação, feita em 2024.

O progresso foi acompanhado por algumas leis melhores no país: em diversas cidades, policiais não devem utilizar identificações positivas como prova única para um pedido de prisão, enquanto outras leis exigem que seja divulgado oficialmente quando ferramentas de reconhecimento facial são usadas durante uma investigação. Todas essas medidas diminuíram a quantidade de prisões injustas e aumentou o escrutínio das ferramentas.

Mas certos problemas ainda persistem, e um deles é uma discussão social que varia de país para país. "No aspecto jurídico, eu vejo que a briga principal será: vale a pena sacrificar a individualidade das pessoas em nome do bem-estar público?", questiona José Mariano de Araújo, especialista em segurança da informação. Em resumo, indivíduos lutarão pelo direito de se manter fora de bancos de dados de reconhecimento facial, enquanto muitos defenderão redes públicas do tipo, com argumentos como "segurança, melhoria do transporte de massa e eficiência dos sistemas de saúde".

Existe também um aspecto temporal, uma vez que sociedades mudam com o tempo. "É importante lembrar que os valores éticos variam substancialmente de acordo com o contexto local e temporal – ou seja, assim como um americano não tem a mesma visão sobre privacidade de um chinês, é possível que um brasileiro em 2040 também não tenha as mesmas preocupações que o brasileiro de 2024, e isso pode ser moldado pelas práticas empregadas pelo poder público,", ressalta o advogado Rony Vainzof.

Escaneamento digital do rosto para identificação

Viktor Braga/Flickr/Universidade Federal do Ceará (Sob Licença Creative Commons)Especialistas em direito civil apontam o Reino Unido como um exemplo de uso equilibrado da tecnologia. Ainda que as ruas do país estejam cheias de câmeras e viaturas que escaneiam rostos a todo momento, não existe um único registro de prisão injusta. É o que afirma o professor dr. Asress Gikay, especialista em inteligência artificial, inovação e direito. "O perigo reside em utilizar a tecnologia como um decisor final, em vez de uma ferramenta sujeita à supervisão humana", afirma Gikay, em um artigo sobre o tema no jornal The Guardian.

Na maior parte dos Estados Unidos, nem os departamentos de polícia ou os promotores são obrigados a dizer que softwares de reconhecimento facial foram usados em acusações. Esse detalhe por si só aumenta grandemente distorções e gera prisões injustas. Um triste exemplo é o de Randal Quran Reid, que foi preso em novembro de 2022, após ser reconhecido por uma tecnologia do tipo e acusado de roubar duas bolsas de luxo. Ele ficou seis dias na cadeia e viu a família gastar milhares de dólares com processos judiciais. Uma investigação do The New York Times descobriu que um gabinete policial usou o Clearview AI na identificação e repassou a informação a outros departamentos, que não questionaram.

Há também preocupações claras com a segurança dos dados coletados, como lembra um caso recente de São Paulo. "Parceiro, precisava saber aonde (sic) esse carro andou [de] sábado até hoje. Consegue dar uma força pra mim pra vê [sic] no Detecta lá". O pedido faz parte de uma troca de mensagens entre integrantes do PCC interceptada pela Polícia Federal. Segundo a PF, o comparsa repassou as informações solicitadas, como ano e local de emplacamento. O carro que foi alvo do rastreamento era da Polícia Civil.

A intercepção foi parte da investigação de um plano da facção de sequestrar autoridades públicas, entre elas o senador Sergio Moro (União Brasil), e revelou que criminosos tinham acesso ao sistema de monitoramento inteligente Detecta, do Governo do Estado de São Paulo.

"Temos indicativo claro de que os investigados têm acesso a dados que deveriam ser sigilosos, o que permite a eles agir com desenvoltura na prática de crimes", escreveu o delegado da PF Martin Bottaro, em um relatório sigiloso, tornado público em 23 de março de 2023.

Câmeras do futuro talvez sejam capazes de ler nossas emoções

@jurvetson/Flickr (Sob Licença Creative Commons)O episódio assustador — criminosos utilizando uma ferramenta de segurança pública para espionar agentes policiais — demonstra que nem os operadores de uma rede de coleta de dados estão imunes. Como evitar erros e invasões, uma vez que é cada vez mais complexo impedir o desenvolvimento ou mesmo controlar o avanço da tecnologia? Nem governantes e muito menos as próprias empresas parecem oferecer soluções efetivas a médio e curto prazo.

No futuro, dados ainda mais sensíveis podem estar disponíveis em tais sistemas de hipervigilância. É o que especula Rony Vainzof. "De forma intrigante, a aplicação psicológica dessa tecnologia desbrava novos horizontes na vigilância, possibilitando análises de microexpressões que revelam os pensamentos e emoções dos observados. Portanto, a capacidade de integrar bancos de dados de imagens e recordar digitalmente eventos passados pode transformar as noções de privacidade e a interação social em espaços públicos, aumentando a sensação de insegurança", finaliza o especialista.